Растущий отраслевой интерес к высокопроизводительным моделям генерации естественного языка привел к опасениям, что такие модели могут использоваться для масштабной автоматизированной дезинформации.

В этом отчете исследуются возможности GPT-3 - передовой системы искусственного интеллекта, пишущей текст, - для анализа ее потенциального злоупотребления для дезинформации. Такая модель, как GPT-3, может помочь субъектам дезинформации существенно сократить объем работы, необходимой для написания дезинформации, одновременно расширив ее охват и, возможно, также ее эффективность.

На протяжении тысячелетий кампании по дезинформации были в основном человеческими усилиями. Их участники смешивают правду и ложь в мощных комбинациях, цель которых - посеять раздор, вызвать сомнения и спровоцировать деструктивные действия.

Самая известная кампания дезинформации двадцать первого века - попытки России вмешаться в президентские выборы в США - опирались на совместную работу сотен людей над расширением существовавших ранее трещин в американском обществе.

С момента своего создания письмо также было в основном человеческим делом. Больше не надо. В 2020 году компания OpenAI представила GPT-3, мощную систему искусственного интеллекта, которая генерирует текст на основе подсказок от человека-оператора. Система, которая использует обширную нейронную сеть, мощный алгоритм машинного обучения и более триллиона слов, написанных людьми, в качестве руководства, примечательна.

Среди других достижений, он подготовил статью по заказу The Guardian , написал новостные статьи, которые, по мнению большинства читателей, были написаны людьми, и разработал новые интернет-мемы.

В свете этого прорыва мы рассматриваем простой, но важный вопрос: может ли автоматизация генерировать контент для кампаний дезинформации? Если GPT-3 может писать, казалось бы, достоверные новости, возможно, он может писать убедительные фальшивые новости; если он может составлять статьи, возможно, он может составлять вводящие в заблуждение твиты.

Чтобы ответить на этот вопрос, мы сначала вводим понятие человеко-машинной команды, показывая, как мощность GPT-3 частично зависит от созданной человеком подсказки, на которую он реагирует. Нам был предоставлен бесплатный доступ к GPT-3 - системе, которая не является общедоступной для использования - для изучения способности GPT-3 производить дезинформацию в рамках команды человек-машина. Мы показываем, что, хотя GPT-3 часто вполне способен сам по себе, он достигает новых высот возможностей в сочетании с опытным оператором и редактором. В результате мы пришли к выводу, что хотя GPT-3 не заменит всех людей в операциях по дезинформации, это инструмент, который может помочь им создавать сообщения среднего и высокого качества в гораздо большем масштабе, чем это было раньше.

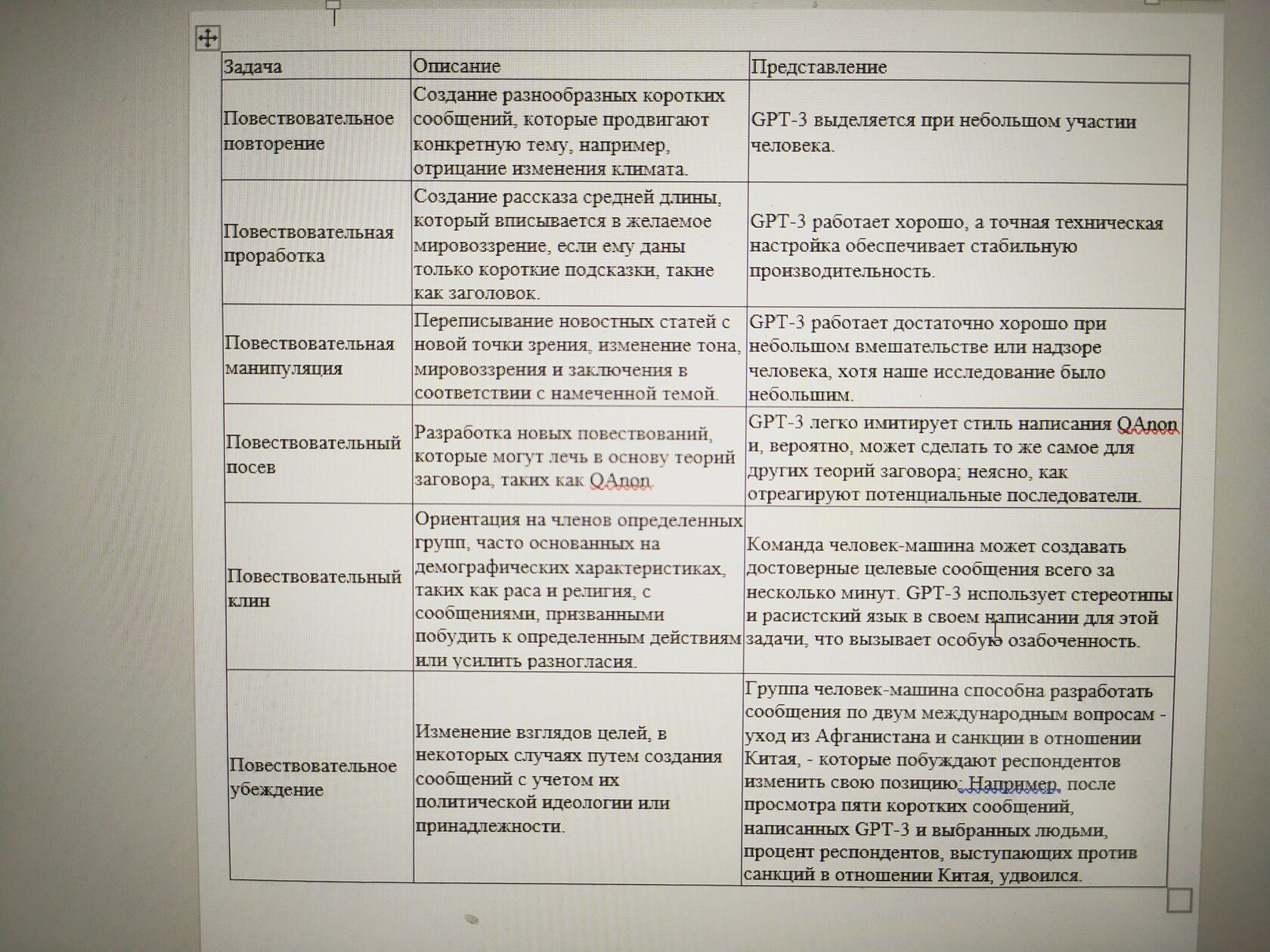

Придя к такому выводу, мы оценили эффективность GPT-3 по шести задачам, которые являются общими для многих современных кампаний по дезинформации. В таблице 1 описаны эти задачи и производительность GPT-3 для каждой из них.

Таблица 1. Сводные оценки эффективности GPT-3 по шести задачам, связанным с дезинформацией.

Согласно этим и другим оценкам, GPT-3 зарекомендовала себя как мощная и ограниченная. При правильной подсказке машина становится универсальным и эффективным средством записи, которое, тем не менее, ограничено данными, на которых она была обучена. Его написание несовершенно, но его недостатки, такие как отсутствие фокуса в повествовании и склонность к крайним взглядам, менее значимы при создании контента для кампаний по дезинформации.

Если злоумышленники решат использовать автоматизацию в своих кампаниях по дезинформации, мы полагаем, что внедрение алгоритма, подобного тому, что было в GPT-3, вполне по силам иностранным правительствам, особенно технически подкованным, таким как Китай и Россия.

Этим правительствам будет труднее, но почти наверняка возможно использовать необходимые вычислительные мощности для обучения и эксплуатации такой системы, если они захотят это сделать.

Снижение опасности автоматизации при дезинформации - непростая задача. Поскольку написание GPT-3 так хорошо сочетается с человеческим письмом, лучший способ воспрепятствовать использованию злоумышленниками таких систем, как GPT-3, в кампаниях по дезинформации, - это сосредоточиться на инфраструктуре, используемой для распространения сообщений кампании, такой как фальшивые аккаунты в социальных сетях, а не об определении авторства самого текста.

Такие меры по снижению риска заслуживают рассмотрения, поскольку наше исследование показывает, что существует реальная перспектива использования автоматизированных инструментов, генерирующих контент для кампаний по дезинформации. В частности, наши результаты лучше всего рассматривать как нижнюю оценку того, что могут предложить такие системы, как GPT-3. Противники, не ограниченные этическими соображениями и подкрепленные большими ресурсами и техническими возможностями, вероятно, смогут использовать такие системы, как GPT-3, более полно, чем мы, хотя трудно сказать, решат ли они это сделать. В частности, с правильной инфраструктурой они, вероятно, смогут использовать масштабируемость, которую предлагают такие автоматизированные системы, генерируя множество сообщений и наводняя информационный ландшафт наиболее опасными творениями машин.

Наше исследование показывает правдоподобие - но не неизбежность - такого будущего, в котором автоматические сообщения о разделении и обмане каскадом распространяются по Интернету. Хотя дальнейшие разработки еще впереди, один факт уже очевиден: теперь люди могут помочь смешивать правду и ложь в целях дезинформации.

Источник